Big Data als Schlagwort gerät hoffentlich bald aus der Mode. Können wir aber große Datenmengen in Power Pivot verarbeiten? Und: Was ist groß?

Fluginformationen aus den USA

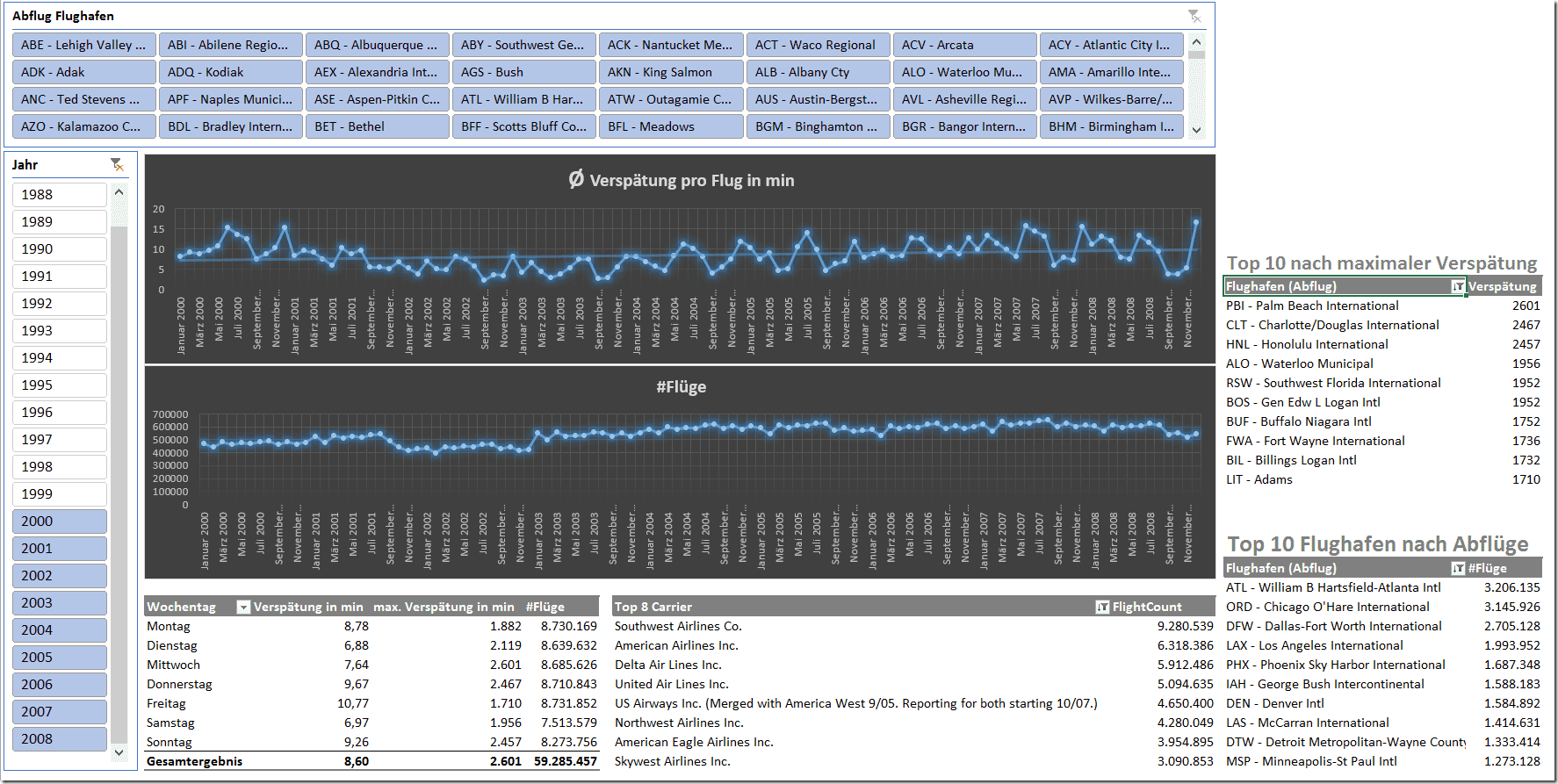

Das Bureau of Transportation Statistics in den Vereinigten Staaten veröffentlicht statistische Daten, beispielsweise eine Verspätungsstatistik aller amerikanischen Flüge. Diese Datenbank haben wir in Power Pivot geladen und ein Dashboard daraus entwickelt:

Aktuell sieht man die Jahre 2000-2008 und hier insbesondere die Zunahme der Verspätungen und die Zunahme der Flüge. Zu den Top 10 Flughäfen gehört natürlich Atlanta, direkt gefolgt von Chicago. Auch sieht man deutlich, dass man am besten mittwochs oder samstags fliegt – wenig verwunderlich, wie ich finde.

Aktuell sieht man die Jahre 2000-2008 und hier insbesondere die Zunahme der Verspätungen und die Zunahme der Flüge. Zu den Top 10 Flughäfen gehört natürlich Atlanta, direkt gefolgt von Chicago. Auch sieht man deutlich, dass man am besten mittwochs oder samstags fliegt – wenig verwunderlich, wie ich finde.

Datenmengen

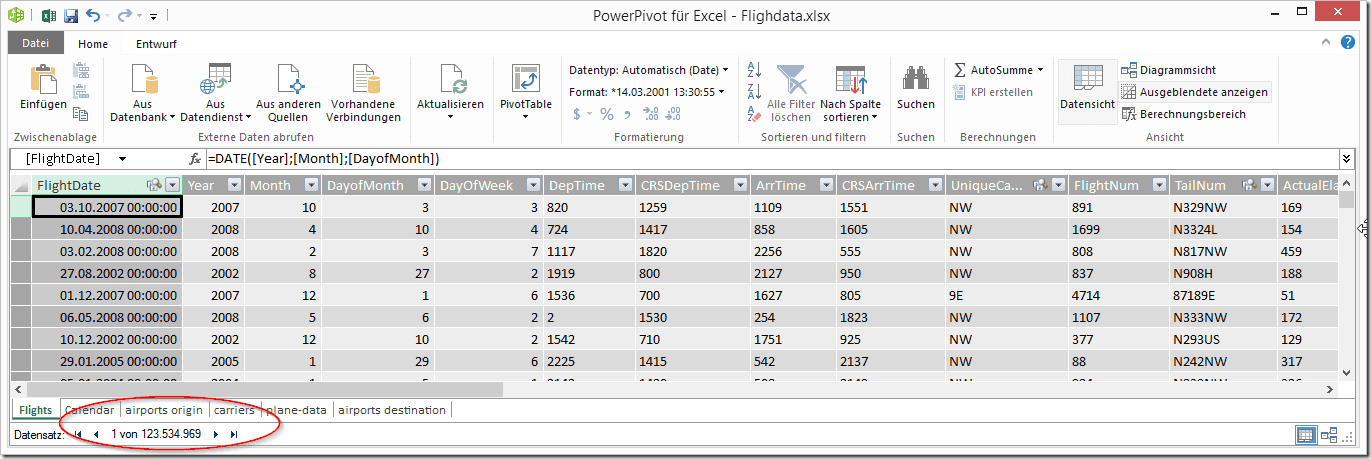

Die Datenbank umfasst alle Flüge, die in den USA gestartet oder gelandet sind, deren Quell- und Zielflughafen sowie die jeweiligen Verspätungen und Verspätungsgründe. Darüber hinaus sind Auswertungen möglich, ob Flüge storniert oder umgeleitet wurden. Insgesamt umfasst die oben gezeigte Datenbank ca. 125 000 000 Datensätze:

Die Datei ist nicht besonders optimiert – viele Daten liegen zur Zeit noch als Zeichenketten vor, da teilweise Angaben mit "N/A" angegeben wurden – was sich natürlich nicht als Zahl umwandeln lässt. Die Datei ist damit größer, als sie optimiert sein müsste. Die Datei hat zu diesem Zeitpunkt auf der Festplatte eine Größe von 2,3 Gigabyte. Das ist natürlich nicht gerade wenig. Dennoch sind die Daten weiterhin auswertbar. Ein 64bit-System ist hier natürlich unumgänglich – diese Zusatzinformation wird in den nächsten 3-5 Jahren aber immer unwichtiger, da 32bit Systeme aussterben.

Die Datei ist nicht besonders optimiert – viele Daten liegen zur Zeit noch als Zeichenketten vor, da teilweise Angaben mit "N/A" angegeben wurden – was sich natürlich nicht als Zahl umwandeln lässt. Die Datei ist damit größer, als sie optimiert sein müsste. Die Datei hat zu diesem Zeitpunkt auf der Festplatte eine Größe von 2,3 Gigabyte. Das ist natürlich nicht gerade wenig. Dennoch sind die Daten weiterhin auswertbar. Ein 64bit-System ist hier natürlich unumgänglich – diese Zusatzinformation wird in den nächsten 3-5 Jahren aber immer unwichtiger, da 32bit Systeme aussterben.

Ist das ausreichend?

Das können wir natürlich nicht mit Ja oder Nein beantworten. Stellen wir die Daten anders dar: Eine Auswertung mit einem Horizont länger als 10 Jahre macht für Unternehmen selten Sinn, da sich die Realität zu sehr verändert – 10 Jahre sind schon ein langer Horizont. Wären wir ein produzierendes oder handelndes Unternehmen, müssten wir am Tag knapp 50 000 Packstücke versenden, um auf 125 000 000 Packstücke in einer Auswertung zu kommen (bei 260 Arbeitstagen pro Jahr):

125 000 000 Packstücke / 10 Jahre / 260 Arbeitstage = 48 076 Packstücke pro Tag

Das gleiche gilt für Kundenaufträge, Buchungen im Buchhaltungssystem, Arbeitsstunden von Mitarbeitern, Supportanfragen, hergestellte Artikel – und viele andere Daten, die man im Unternehmensalltag auswertet.

Fazit

Sie werden damit nicht die Nutzungsstatistik von Google weltweit auswerten können. Auch nicht Telefonate, die die NSA täglich abhört – auch wenn es nur die Metadaten sind... Die 90% der Datenanalysen, die man in Unternehmen täglich durchführen möchte, sind aber sicherlich gedeckt. Außerdem sind die 125 000 000 Daten aus dem Beispiel nicht die obere Grenze.

Kommentar hinterlassen