Falls Sie eine Definition für eine Studienarbeit suchen, gehen Sie zu Wikipedia. Falls Sie nach dem Thema suchen, weil Sie das Gefühl haben, bei Ihnen könnte bei dem Thema vieles besser laufen oder Sie brauchen eine Einordnung, dann ist dieser Artikel für Sie.

Wozu eine Definition zu Business Intelligence?

Einen Marketing Begriff zu definieren fällt - gelinde gesagt - schwer. Für Business Intelligence oder kurz BI gibt es viele "Definitionen". Eine definiert BI über seine Vorteile:

- Beschleunigung und Verbesserung der Entscheidungsfindung

- Ermittlung von Wettbewerbsvorteilen gegenüber der Konkurrenz

- Trenderkennung

- Aufdecken von Wachstumsbereichen, die angegangen werden müssen

- Verbesserung der internen Prozesse interner Geschäftsprozesse

- etc.

Oder bei Wikipedia:

Mit BI sind [...] Verfahren und Prozesse zur systematischen Analyse des eigenen Unternehmens bezeichnet. Dies umfasst die Sammlung, Auswertung und Darstellung von Daten in elektronischer Form.

Es gibt keine einheitliche Definition für Business Intelligence. Das Gebiet ist dafür zu groß, in einem zu schnellen Wandel und die Werkzeuge und Methoden zu vielfältig.

Letztlich geht es um den Erkenntnisgewinn aus vorhanden Daten, um am Schluss mehr Geld zu verdienen.

Business Intelligence - eine Bestandsaufnahme

In Ihrem Unternehmen setzen Sie bisher auf ein älteres MIS-System (Management Information System): Die Datenstrukturen sind zu alt, Änderungen dauern zu lang und außerdem sind viele Unternehmensbereiche nicht integriert.

Alternativ nutzen Sie seit längerem Werkzeuge, wie QlickView, Tableau, Crystal-Reports, Cognos oder SAP und dann selbstverständlich SAP BW (SAP Business Warehouse).

Excel haben Sie im Einsatz. Klar haben Sie das. Und ich bin mir sicher, dass damit essentielle Auswertungen gemacht werden. Trotzdem geht Ihnen alles zu langsam. Umsatzdaten erhalten Sie erst im Laufe des nächsten Monats. Budgetplanungen lasten Ihrer ganze Controlling-Abteilung für einen Monat aus. Sie nutzen QlikView oder SAP BW - dort wird aber die Export to Excel Funktion häufiger ausgeführt als das fertige Berichte genutzt werden. Die Werkzeuge sind teuer und bei Themen wie Big Data, Machine Learning & Co fühlen Sie sich abgehängt.

Lassen Sie uns an diesem Punkt Business Intelligence dekonstruieren und aktuelle Themen einordnen.

Business Intelligence dekonstruiert

Was brauchen Sie unbedingt für Business Intelligence? Was brauchen Sie nur vielleicht? Und was könnten Sie in Zukunft brauchen?

Daten

In erster Linie brauchen Sie Daten! Und zwar in elektronischer Form zugreifbar.

Ihre Daten sind in mehreren Systemen verstreut. Das "eine integrierte System" ist allerdings nie vorhanden. Kann gar nicht, denn Sie erhalten Daten auch von extern: von Lieferanten oder Kunden, Sie nutzen Börsen- oder Wetterdaten. Klar kann die Daten in Systeme importieren (der SAP BW oder auch SAP HANA Ansatz). Diesen Anforderungen rennen Sie immer hinterher. Weil sich die Datenlage oder Anforderungen schneller ändern als Sie einen Entwickler finden.

Es gibt einen Grund, warum täglich Daten aus verschiedenen Systemen exportiert und dann in Excel mit SVerweisen ausgewertet werden.

Die leidige Archivierung

Wie gehen Sie mit Altdaten um? Vielleicht haben Sie sich darüber noch nie Gedanken gemacht. Es ist ja alles im System und bleibt auch dort. Allerdings wird das "System" durch viele Daten irgendwann zu langsam.

Problematisch wird es bei einer Systembereinigung. Falls Sie sich erst danach für eine Auswertung über Altdaten entscheiden, sind diese nicht mehr vorhanden. Also brauchen Sie vorher ein Archivierungs-Konzept.

Wenn Sie in Ihrem System keine Daten löschen, das Datenaufkommen nicht stark anwächst oder Sie nur die letzten drei Jahre auswerten, dann brauchen Sie sich wenig Gedanken zu machen.

Andernfalls müssen Sie archivieren. Manchmal bieten Systemanbieter Konzepte dafür an. Achten Sie darauf, dass Sie auf die archivierten Daten auch ohne Ihren Systemanbieter Zugriff haben. Im einfachsten Fall exportieren Sie alle zu archivierenden Daten in CSV-Dateien und legen diese ab bevor Sie die Daten aus Ihrem System löschen.

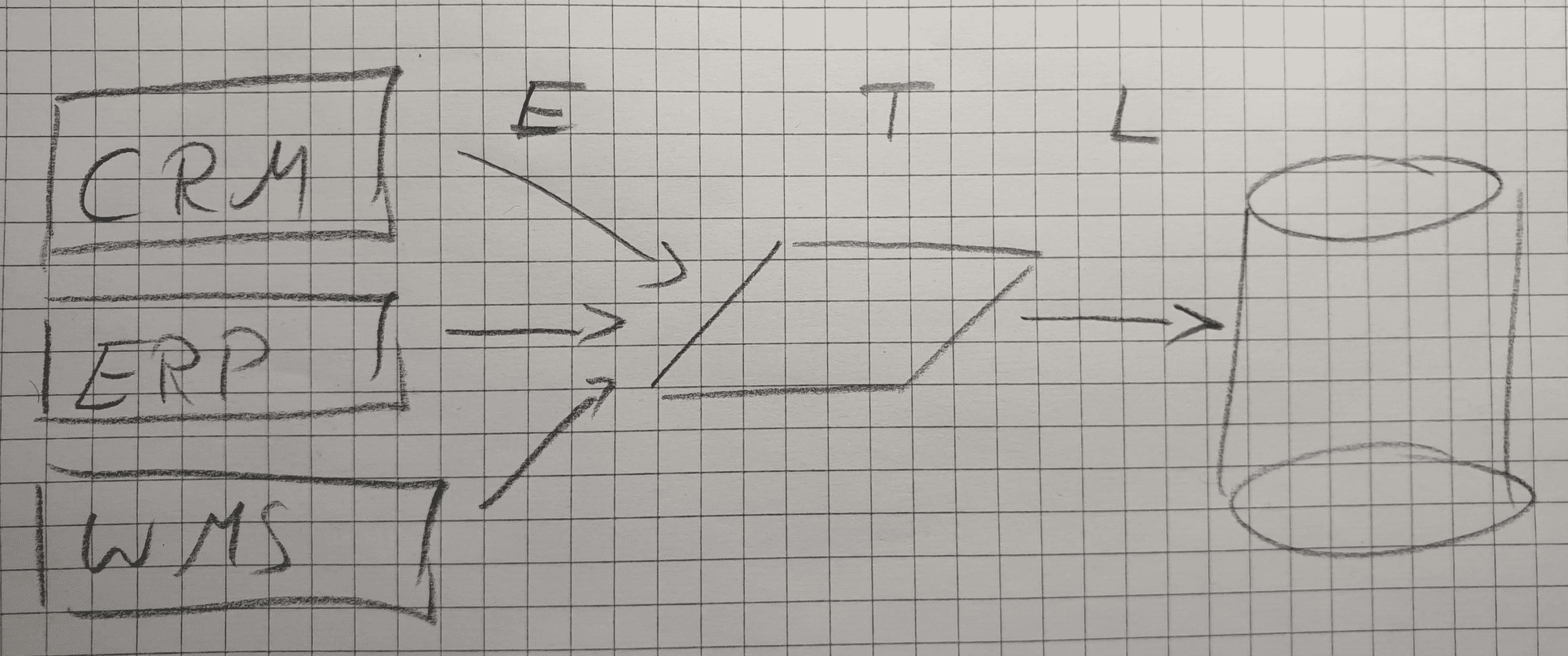

Datenqualität - der ETL-Prozess

Doppelte Artikelnummern, mehrfach angelegte Kunden, obsolete Lieferbedingungen, fehlerhafte Kostenstellen, fehlende Datumsinformationen oder Datumsinformationen in der Zukunft. Die Liste der möglichen Datenfehler ist endlos.

Bevor Sie Daten auswerten können, müssen sie in ein einheitliches Format gebracht oder korrigiert werden. So müssen Sie ein SAP-Datum im Format yyyyMMdd erst umformen, SAP-Gewichte immer durch 1.000 teilen oder logische Werte von 0/1, X/- oder Wahr/Falsch in True,False umwandeln. Fehlt teilweise das Versanddatum nehmen Sie das Bestelldatum und addieren eine mittlere Produktionsdauer. Doppelte Artikelnummern müssen Sie zusammenfassen.

IT gestützte Werkzeuge, die so etwas anbieten, nennen sich ETL-Tools für Extract Transform Load. Das bedeutet, Daten werden zuerst aus den Quellsystemen geladen (Load), dann werden diese angepasst (Transform) und am Ende zur Verfügung gestellt (Load).

Aber wem werden die Daten zur Verfügung gestellt?

ETL - und jetzt?

Wenn Ihr ETL-Prozess ein paar Sekunden dauert, dann können Sie die Ergebnisse direkt in einem Bericht darstellen. Entweder druckfähig (wirklich? Ausdrucken?) oder Web-basiert (besser verfügbar für Nutzer).

Dauert der ETL Prozess etwas länger, bietet es sich an, das bereinigte Ergebnis abzulegen. In eine irgendwie geartete Datenbank. Das kann eine SQL-Datenbank sein, das kann auch etwas anderes sein. Wenn Nutzer einen Report anschauen, wird der ETL-Prozess nicht jedesmal neu durchlaufen. Die Daten im Report sind aber auch nicht mehr brandaktuell. Weiter unten im Beitrag schauen wir uns an, was man unter Datawarehouse oder DataLake versteht.

Kennzahlen berechnen

Dann möchte man auf Grundlage der Daten noch Berechnungen durchführen:

- Wie war der Umsatz im jeweiligen Vorjahr/Vormonat?

- Was sind meine Top 10 Produkte nach Umsatz oder Anzahl Kunden?

- Welche Kunden hatten im Vergleich zum Vormonat einen Umsatzeinbruch?

Hier steht man vor der selben Herausforderung wie beim ETL-Prozess:

- Soll man die Kennzahlen vorher berechnen und ablegen?

- Soll man die sie Ad-hoc berechnen wenn der Benutzer einen Report öffnet?

- Oder eine Misch-Lösung (Entschuldigung, heute sagt man Hybrid-Lösung ), also Vorberechnung und Ad-hoc?

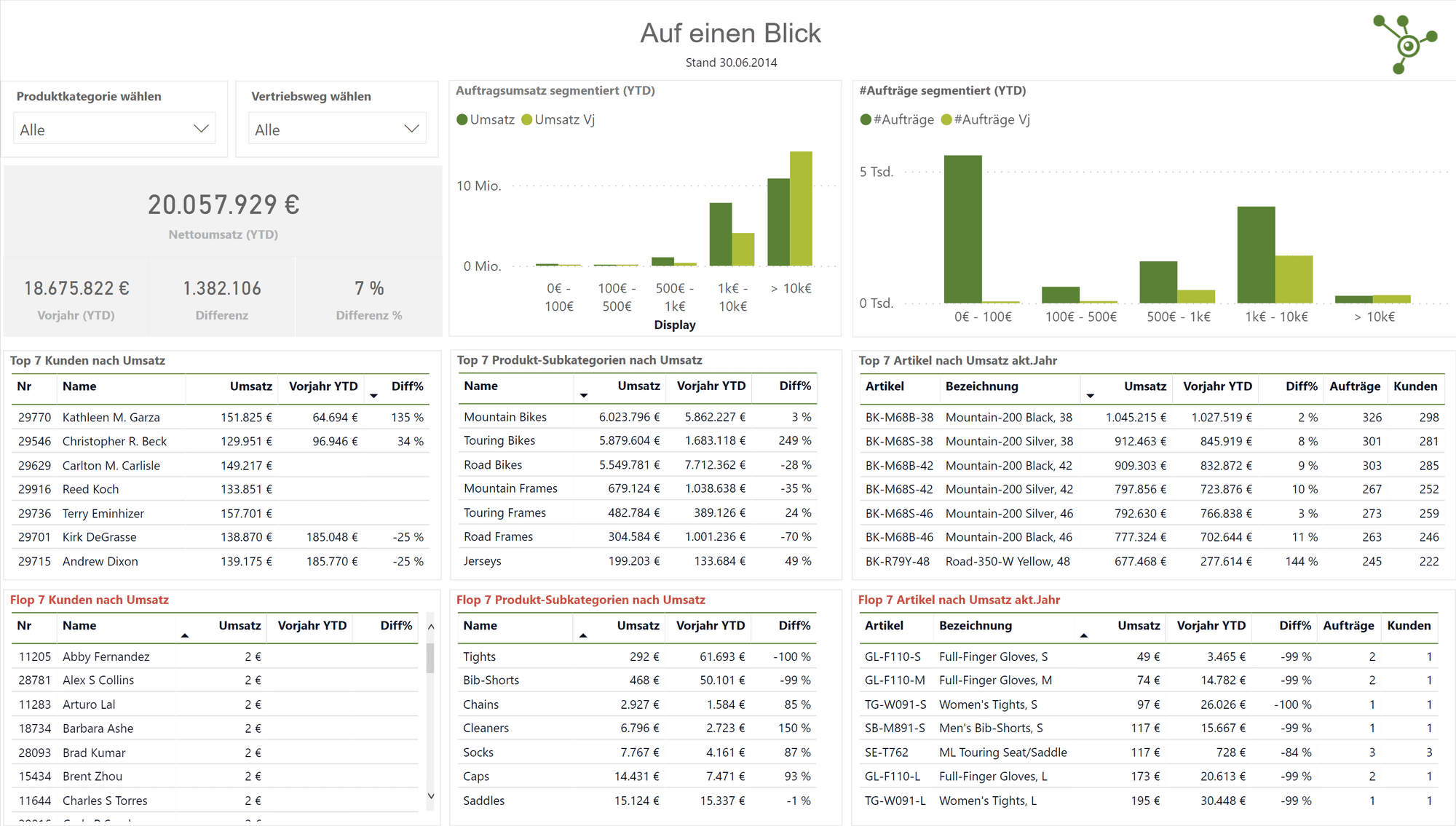

Bunte Bilder

Die Darstellung am Schluss ist die Kür. Aus vorberechneten Daten Säulendiagramme oder Pivot-Darstellungen zu machen ist nicht mehr schwierig. Ein bisschen Unternehmensfarbe und das Logo einfügen schon fühlen sich alle eingebunden. Das stimmt natürlich nicht ganz: Gut gemachte Reports sind auch eine Kunst.

Das ist aber eine wichtige Erkenntnis: Das, was man gemeinhin als Report-Generator bezeichnet, also der Teil der Lösung, der die bunten Bilder malt, das ist eigentlich der unwichtigste.

Vorhandene BI-Werkzeuge - und Self Service BI

Die genannten Schritte, also Verbinden der Datenquellen, Transformieren und Bereitstellen der Daten werden von BI-Softwareprodukten angeboten. Teilweise umfänglich, teilweise nicht.

Bisher (teilweise immer noch) haben spezialisierte Berater Datenquellen verbunden, notwendigen ETL-Prozesse definiert, Kennzahlen in komplizierten Sprachen entwickelt und am Ende Reports erstellt. Diese Vorgehensweise ist zu starr. Änderungen, die häufig vorkommen, verlangen immer eine Änderung durch spezialisierte Berater.

Im Self-Service BI Ansatz möchte man die Zielgruppen, nämlich den Fachbereich, selbst befähigen, Auswertungen zu erstellen. Eigentlich tun die das ja eh schon - allerdings mit Excel.

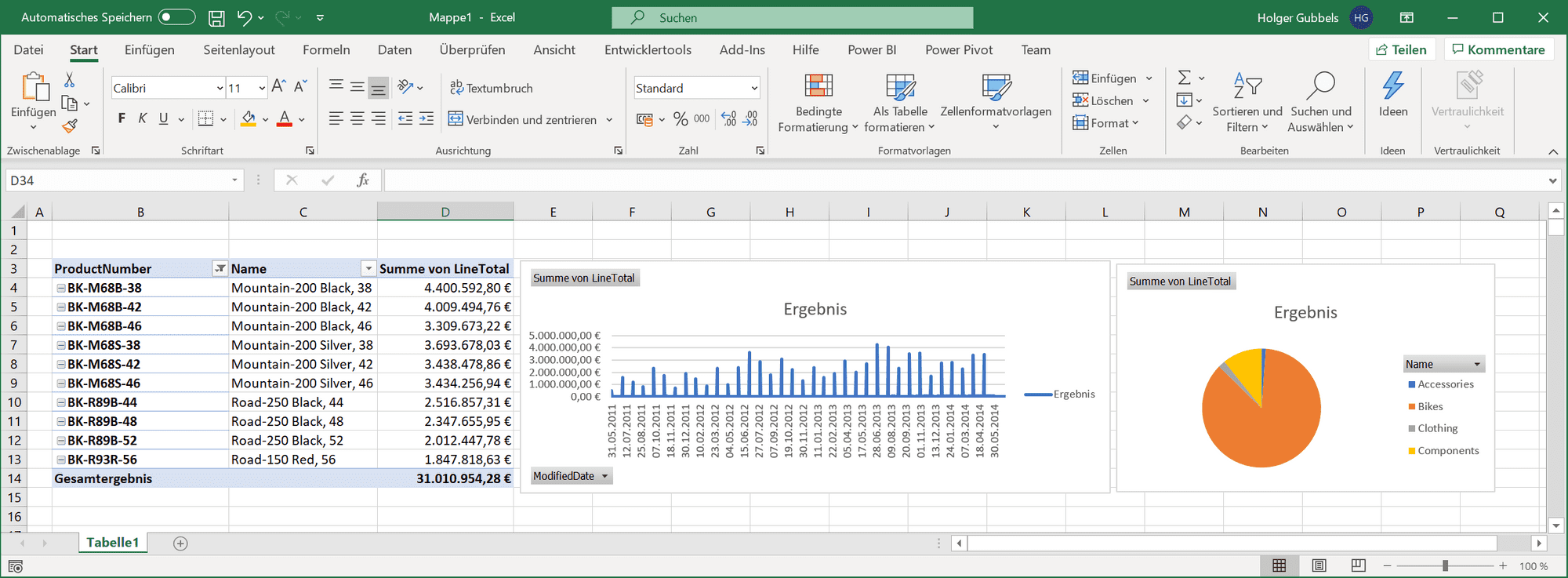

Der Excel Ansatz

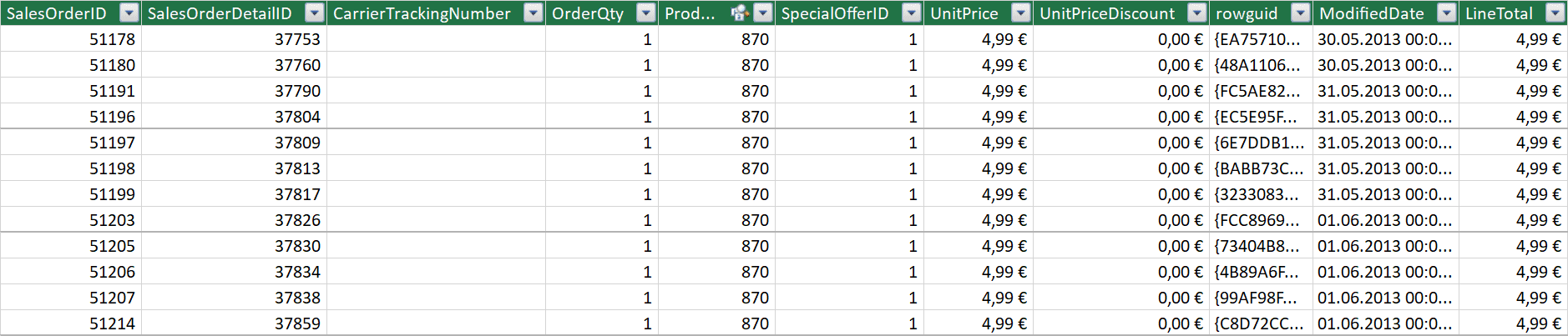

Die oben beschriebenen Schritte vollziehen täglich tausende von Menschen:

- Load: Aus SAP BW werden mit dem BEX-Analyzer Daten exportiert, aus QlikView CSV-Dateien abgespeichert

- Transform: In Excel werden die Daten in Arbeitsmappen geladen und über SVerweise zusammengeführt

- Load: Die Ergebnisse landen wiederum in Excel in einer teilweise großen, zweidimensionalen Matrix in einem Tabellenblatt

Die Darstellung erfolgt mittels Pivot-Diagrammen und -Tabellen. Kennzahlen können bedingt über die eingebauten Aggregat-Funktionen, wie SUMME, ANZAHL, MIN/MAX oder MITTELWERT berechnet werden.

Bei einer Million Zeilen ist definitiv Schluss.

Warum Daten exportiert und in Excel weiterverarbeitet werden - würde man bei SAP BW noch verstehen. Die Reports in SAP sind nicht ganz so einfach zu bedienen und nicht so sexy, wie man sie gerne hätte. Aber warum auch beim Einsatz anderer Werkzeuge?

Oft basieren diese Werkzeuge intern doch wieder auf einem Datenmodell, das von spezialisierten Mitarbeitern aufgebaut worden ist. Änderungen dauern also wieder zu lang. Da man Antworten meistens gestern benötigt - nimmt man letzlich doch wieder Excel.

Big Data, Machine Learning & Co

Über die Jahre sind im BI-Umfeld noch mehr Marketing- und Buzzwords entstanden. Technische Lösungen sind teilweise beeindruckend, die Bezeichnungen im Allgemeinen irreführend. Begrifflichkeiten überschlagen sich.

OLAP, Datamart, Datawarehouse

ETL - und dann?

Weiter oben haben wir gesehen, dass man transformierte Daten nach dem ETL-Prozess ablegen kann, um sie nicht immer neu berechnen zu müssen. Oder zweistufig: erst Daten aus dem Quellsystem kopieren und ablegen (=> das ist auch ein Archvierungskonzept!). Später diese kopierten Daten im ETL-Prozess bereinigen und wiederum ablegen. Und jeweils das für alle Quellsysteme und Daten.

Egal welche Variante Sie nehmen, das Ablagesystem nennt man landläufig Datawarehouse. Ein bisschen wie ein Supermarkt für Daten.

Auf den Daten wollen wir jetzt Kennzahlen berechnen. Und das geht eben Ad-hoc, vorberechnet oder beides ein bisschen. Meist basiert ein Datawarehouse auf einer relationalen Datenbank. Es nutzt also dieselbe Technologie wie ein Auftragssystem oder CRM. Diese Art von Datenbanken spricht man mit SQL an. SQL ist eine tolle Sprache, wenn man in einem Auftragssystem einen Auftrag sucht, einen Kunden anlegt, einen Artikel ändert oder eine Reservierung löscht. Um den Umsatz YearToDate (also Anfang des Jahres bis heute) pro Monat pro Land zu berechnen, ist SQL nicht optimal. BI-Tools, die direkt auf SQL-Datenbanken basieren, sind daher langsam.

Daher gibt es noch weitere Systeme on top auf einem Datawarehouse. Sogenannte OLAP-Datenbanken. OLAP (Online Analytical Processing) ist die Idee, dass ein Benutzer in vorgegebenen Grenzen Daten selbst auswerten kann und zwar möglichst ohne eine komplizierte Sprache erlernen zu müssen. Und damit die Anfragen (die dann ja nicht planbar sind) nicht zu lange dauern, bereitet man diese vorher auf. Den Umsatz pro Tag, Woche, Monat und Jahr hat man über Nacht vorsichtshalber schon zusammengezählt. Eine OLAP Datenbank lädt also periodisch die Daten aus dem Datawarehouse und bereitet sie für die Auswertung auf.

Diese Vorberechnungen müssen natürlich begrenzt werden. Die Budgetplanung im Controlling mit Durchlaufzeiten von Fertigungsaufträgen in ein Modell zu gießen ist vermutlich Unsinn. Daher steckt man Bereiche ab: beispielsweise Controlling, Logistik und Produktion. Eine Auswertung kann dann entweder im Bereich Logistik oder im Bereich Controlling stattfinden. Da "Bereich" irgendwie nicht sexy genug klingt und man mit Datawarehouse schon ein bestimmtes Bild erzeugt hat, entstand der Begriff Datamart. Ein "Datenmarktplatz" auf dem man sich bedienen kann.

Zur Erinnerung: Wenn Sie Ihre Daten nicht aus Ihren Systemen löschen, haben Sie kein Problem.

Und noch ein Begriff: DataLake

Mit Datawarehouse verbindet man feste Strukturen, meist Tabellenstrukturen. Dieses Schema (der Aufbau einer konkreten Tabelle) ist starr. Wenn plötzlich für alle Kunden Geburtsdaten gepflegt werden und ausgewertet sollen, muss man dieses Schema ändern. Außerdem muss man sich Gedanken über Altdaten machen. Alternativ nimmt das Geburtstdatum nicht mit in das Datawarehouse und ärgert sich dann Jahre später, dass man das nicht gemacht hat. Die Daten aus den Quellsystemen sind dann aber unter Umständen nicht mehr vorhanden.

Was wäre aber, wenn man alle Daten einfach irgendwo hinwirft? Und zwar so, wie diese aktuell zur Verfügung stehen? Heute ohne Geburtsdatum, morgen noch ein Produktbild dazu und übermorgen noch ein Video? Einfach aus dem Grund, weil man noch nicht weiß, was man irgendwann mal auswerten will? Vielleicht machen wir noch eine Ordner-Struktur darüber. Einen Ordner für Produktbilder, einen für Kundendaten, einen weiteren für Bestellungen und darunter noch Ordner pro Bestellmonat und Jahr.

So eine Ablage kennen Sie schon? So sieht Ihr Netzlaufwerk im Unternehmen aus?

Im BI-Umfeld nennt man so etwas DataLake. Das ist natürlich nicht ganz richtig. Wenn Sie ein Produkt DataLake verkaufen möchten, benötigt das schon etwas mehr Funktionalität als Ihr Netzlaufwerk.

Wenn Sie mit Daten aus Ihrem Netzlaufwerk Auswertungen machen wollen, brauchen Sie wieder den oben besprochenen ETL-Prozess. Wenn Sie wissen wollen, wie oft der Kunde "Huber" bei Ihnen "Schokoriegel" bestellt hat, dann müssen Sie die Bestelldaten (CSV-Dateien) mit den Kundendaten (Excel) in anderen Formaten wieder zusammenbringen, um sie dann auswerten zu können.

Oder wenn Sie anhand von Bilderkennung herausfinden möchten, wie viele Produkte aktuell rot sind? Oh Gott - Bilderkennung? Jetzt auch noch Machine Learning? Ja - na und? Ist am Ende auch nur ein Schritt in Ihrem ETL-Prozess. Ergebnis: "Produkt A rot", "Produkt B rot", "Produkt C nicht." Ergebnis: Zwei Produkte rot, eins nicht.

Um dieses "Suchen" nach "Huber" oder nach roten Bildern möglichst effizient zu gestalten, bieten sich herkömmliche Dateisysteme nicht an. Das kennen Sie aus eigener Erfahrung, wenn Sie den Ordner mit dem Windows Explorer durchsuchen. Vor allem muss das System skalierbar sein. Nach Gigabyte kommt Terrabyte und dann kommt Petabyte. Mit solchen Datenmengen muss ein solcher DataLake zurecht kommen.

Hadoop und HDFS

Um skalierbar zu sein bedient sich ein solcher DataLake beispielsweise dem Hadoop Distributed File System. Was ist jetzt aber Hadoop? Hadoop ist ein skalierbares Verfahren für Suchen auf verteilten Daten. Beispielsweise Daten in einem solchen DataLake.

Stellen Sie sich vor, Sie möchten aus einem Telefonbuch alle Telefonnummern haben von Leuten, die ein "e" als dritten Buchstaben im Nachnamen haben. Dann haben Sie die Möglichkeit das Telefonbuch einfach sequentiell zu Durchsuchen. Das dauert.

Alternativ holen Sie sich 26 Mitarbeiter, teilen das Telefonbuch anhand der Anfangsbuchstaben der Nachnamen und geben je einen Teil an einen Mitarbeiter. Am Ende erhalten Sie 26 Ergebnisse und müssen diese nur noch zusammenzählen. Wir sind uns einig, dass der Kollege mit Buchstabe "X" vermutlich früh Feierabend hat...

Google hat vor vielen Jahren ein solches Verfahren mit Namen Map & Reduce entwickelt. Hadoop ist eine Implementierung dieses Verfahrens. Das Hadoop Distributed File System ist ein dafür entwickeltes Speicherverfahren für Dateien. Diese werden aufgeteilt und auf vielen Rechnern verteilt gespeichert. Vergleichbar mit dem geteilten Telefonbuch.

SPARK

Hadoop hat allerdings einen Nachteil: Es basiert auf Dateispeicherung in einem Dateisystem. Arbeitsspeicher wird aber immer billiger. Und wir alle wissen: Der Datenzugriff im Arbeitsspeicher ist bedeutend schneller als der Zugriff in einem Dateisystem. Also: Warum lädt man nicht alles in den Arbeitsspeicher?

Da Hadoop auf Dateien spezialisiert ist benötigt man ein neues Verfahren: SPARK ist ein solches Verfahren. SPARK arbeitet ca. Faktor 100 mal schneller als Hadoop.

Tatsächlich arbeiten SPARK und HADOOP gut zusammen. So nutzt man SPARK für Berechnungen auf Daten, die einem Hadoop-Filesystem gespeichert sind.

Machine Learning, Deep Learning, Künstliche Intelligenz

Das Thema wird aktuell heiß diskutiert. Die Inhalte sind aber absolut nicht neu. Geändert hat sich allerdings der Zugang zur Technologie. Während man früher viele Rechner kaufen musste, um einen Mehrwert aus den Algorithmen zu bekommen, kauft man sich heute Rechenzeit in der Cloud. Bei Anbietern wie Amazon oder Microsoft ist man nur ein paar Mausklicks und eine gültige Kreditkarte davon entfernt.

AI oder Artifical Intelligence ist zu deutsch: KI - Künstliche Intelligenz. Machine Learning (ML) ist ein Teilbereich der KI, Deep Learning (DL) ist wiederum ein Teilbereich von Machine Learning.

Ein ML-Algorithmus wird nicht programmiert, sondern trainiert. Das bedeutet, es gibt viele bekannte Verfahren, die ausgewählt und dann trainiert werden möchten.

Beispiel: Aus Ihren Daten wissen Sie, wenn ein Auto von Hersteller A ist, mit Diesel fährt und älter als 10 Jahre ist, dann erzielen Sie einen Verkaufspreis im Bereich X-Y. Davon haben Sie tausende Datensätze. Dem gewählten ML-Verfahren setzen Sie diese Informationen jetzt vor - allerdings nur die Hälfte der Daten. Der Algorithmus versucht herauszufinden, wie diese Entscheidungen getroffen wurden.

Und dann nehmen Sie den zweiten Teil Ihrer Daten und füttern Ihren trainierten Algorithmus mit den Ausgangsdaten. Dieses Mal aber ohne die Ergebnisse. Ihr ML-Algorithmus spuckt nun selbst Ergebnisse aus. Diese vergleichen Sie mit Ihren bekannten Daten. Und je nachdem, wie sehr der Algorithmus abweicht, müssen Sie Hand anlegen, Parameter ändern, Verfahren austauschen.

Deep Learning ist eigentlich nur ein ML-Verfahren. Hier wird das menschliche Gehirn als Vorlage genutzt. Es werden Neuronenstrukturen nachgebildet. Mit den Trainingsdaten bilden diese Strukturen Pfade und Gewichtungen. Bei diesen Neuronalen Netzen kommt es auf die Anzahl Eingangs und Ausgangsneuronen sowie die Anzahl Neuronen im Netz an. Die Ermittlung guter Strukturen ist eine Wissenschaft für sich. Das Training verläuft aber wie bei anderen ML-Verfahren.

BI und operational BI

Hier gilt es noch etwas zu unterscheiden. Alles bis hierhin beschriebene ist klassisches, historisches BI. Wir schauen in die Vergangenheit und extrapolieren eventuell die Zukunft (beispielsweise Forecasting bei Budgetplanungen).

Operational BI zeigt aktuelle Kennzahlen auf Daten, die teilweise nur Sekunden alt sind: offene Bestellungen mit Lieferfrist, Anrufer in der Warteschlange, Arbeitsvorrat in der Fertigung. Hier spielt Machine Learning ebenfalls eine Rolle: Bei Nutzung einer Kreditkarte kann man anhand von Nutzerdaten einen trainierten Algorithmus bewerten lassen, ob es sich vielleicht um einen Betrugsversuch handelt (Fraud Detection). Hier bewerten wir also nicht historische Daten sondern aktuelle mit einem ML-Algorithmus.

Fazit

Business Intelligence ist ein weites Feld, immer mehr Begriffe und Technologien kommen auf den Markt, die Aufgaben bleiben aber letztlich die gleichen.

Ob bei Ihnen Excel genügt (haben Sie sich mal Excel Power Pivot angesehen?), ob Sie gerne mal Power BI testen möchten oder ob Sie eine Lösung mit eigenem DataLake benötigen. Sprechen Sie uns an!

Wir nutzen die Technologien von Microsoft Azure:

- Power BI zur Datenauswertung und für das Reporting

- Azure DataLake zur Datenablage

- Azure HDInsight mit Diensten wie Hadoop oder Spark

- Azure Databricks, ein Dienst ebenfalls für SPARK

Schreiben Sie uns oder rufen direkt an!

Kommentar hinterlassen